Ollama是什么?

Ollama 是一个允许用户在本地设备上运行和管理大型语言模型(LLM)的平台,提供隐私保护、低延迟和多种模型支持。它适合开发者、企业和个人用户,支持通过图形界面或API进行交互,并支持跨平台使用。

当前我的环境

设备有限只有一张3060 12gb显卡,平时用来轻度学习

主机:windows server

Ollama:windows版(它也有linux和mac) 因虚拟机使用的服务器无显卡,只用来跑面板和WebUi

虚拟机:ubuntu server

linux面板:1panel 专业版

webui:Ollama WebUI

windows server需要做的操作

安装Ollama

Ollama 是一个用于部署本地 AI 模型的工具,开发者可以在自己的机器上运行模型,并通过 API 接口调用。

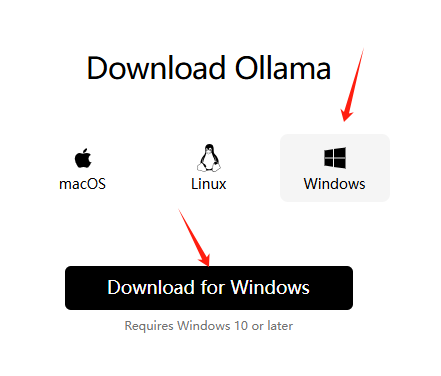

1、打开Ollama官方网址

2、下载windows版本

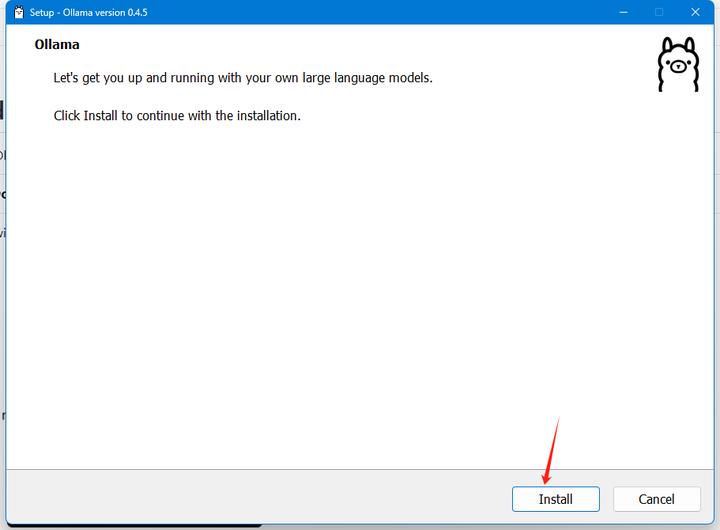

3、一键安装-点击install

安装完成右下角会有一个图标

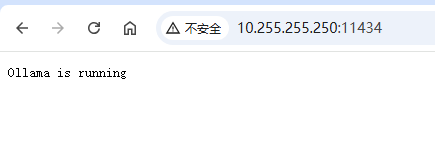

这时候如果无法通过http://ip:11434 正确访问的话,请看下面坑点,进行修复

坑点1:无法通过局域网访问

在本地搭建 Ollama 服务后,默认只允许本地访问,而局域网中的其他设备无法直接访问该服务。

设置 Ollama 的环境变量 OLLAMA_HOST,使其监听局域网的 IP 地址。

设置环境变量

在 Windows 中,可以通过以下步骤来设置环境变量 OLLAMA_HOST:

打开系统属性:

右键 此电脑 -选择 属性

点击 高级系统设置

环境变量:

在弹出的窗口中,点击 环境变量

新建系统环境变量:

在 系统变量 部分,点击 新建。

在 变量名 中,输入 OLLAMA_HOST

在 变量值 中,输入 0.0.0.0,点击 确定。

重启:

确认保存后,重启电脑,重新打开软件

坑点2:windows防火墙

这个时候你会发现通过 http://ip:11434依旧无法局域网访问的话,大概率就是防火墙的问题

你开启了windows防火墙,该如何正常访问?

关闭防火墙(内网环境!)

点击 开始-设置-更新和安全

点击 windows安全中心-防火墙和网络防护

点击 域网络/专用网络/公用网络 关闭即可

在 Windows 防火墙中开放 Ollama 服务使用的端口(11434)

打开 控制面板,搜索 Windows Defender 防火墙 点击它

在左侧点击 高级设置,进入高级防火墙设置页面

在左侧菜单中,点击 入站规则,在右侧点击 新建规则

选择 端口 作为规则类型,点击 下一步

选择 TCP,并在 特定本地端口 一栏中输入 11434,点击 下一步

选择 允许连接,点击 下一步

根据需求选择应用的网络类型(域、专用或公用),点击 下一步

为这条规则命名(“Allow Ollama Port 11434”),点击 完成

1Panel 需要做的操作

一键安装linux面板-1panel面板

curl -sSL https://resource.fit2cloud.com/1panel/package/quick_start.sh -o quick_start.sh && sudo bash quick_start.shhttps://1panel.cn/docs/installation/online_installation/

根据你当前的系统类型使用不同的一键安装脚本

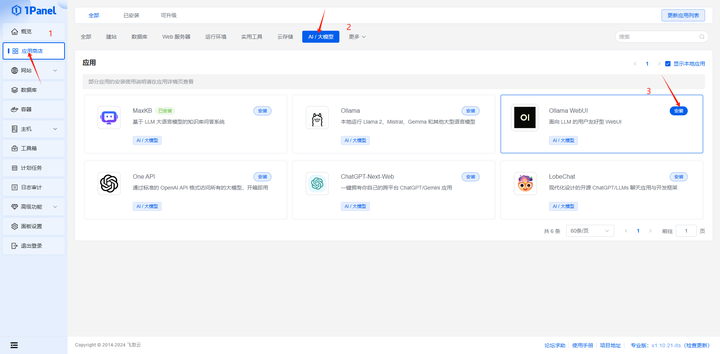

1panel一键安装Ollama WebUI

1、打开应用商店 - AI/大模型 - Ollama WebUI - 安装

2、填写Ollama服务地址 -开启端口外部访问-点击确认

安装后通过ubuntu server 的IP+端口访问

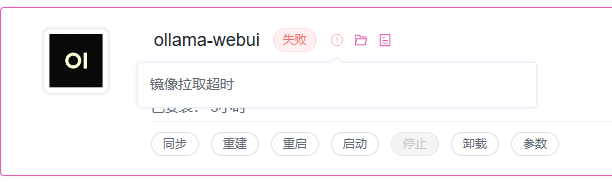

坑点1:由于docker 被墙,拉取镜像超时的问题

镜像加速地址一般是公用,速度是有限制的,有需求建议自建私用或者http代理,速度会快很多

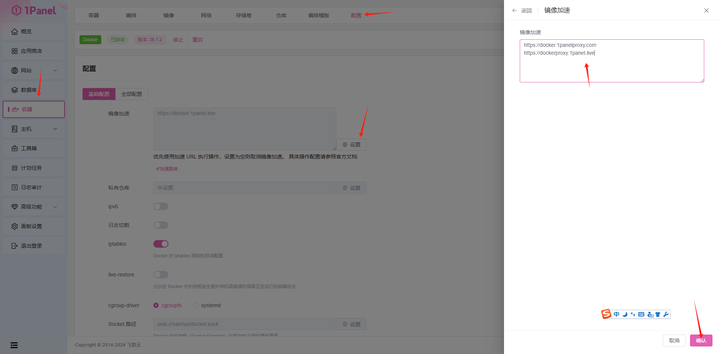

解决方法1:使用docker镜像加速地址

使用下列网址,可以查看当前可用的加速地址

https://status.1panel.top/status/docker

打开1panel后台-容器-配置

基础设置 -镜像加速-点击设置-输入镜像加速地址(可多个)-点击确认

输入立即重启 -点击确认

自建加速地址方法:

https://github.com/cmliu/CF-Workers-docker.io https://github.com/mzzsfy/Dockerfile/blob/main/cf-worker/docker-image.js

https://github.com/tech-shrimp/docker_image_pusher https://github.com/dqzboy/Docker-Proxy

使用http(s)/sk5 代理

使用私人docker仓库

Ollama WebUI 基本设置

我这边是http://10.255.255.242:3000 访问地址

创建账号

输入名称-邮箱-密码 点击创建账号

添加模型

点击右上角账户-管理员面板

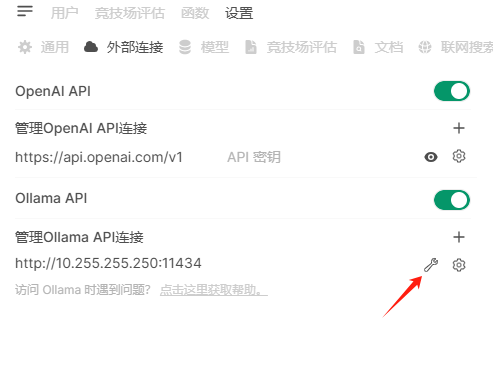

点击设置-点击外部链接

找到Ollama API -点击管理

点击下面的网址模型搜索-查找模型-根据提示输入模型名称-下载

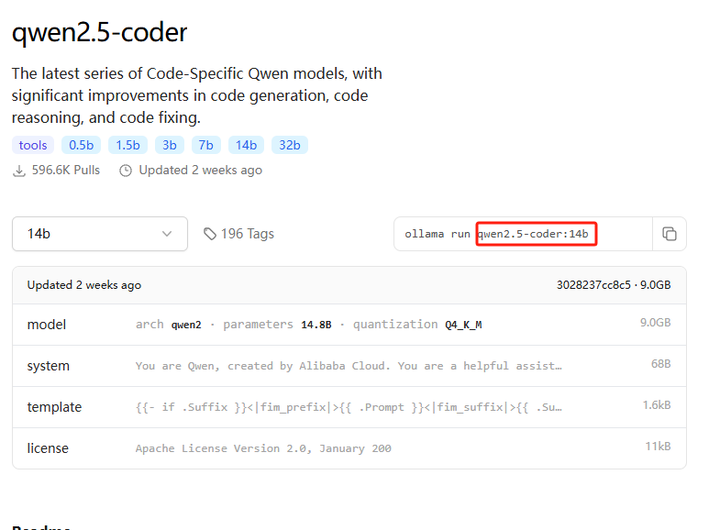

比如我使用qwen2.5-coder:14b 就输入这个下载就行 https://ollama.com/search

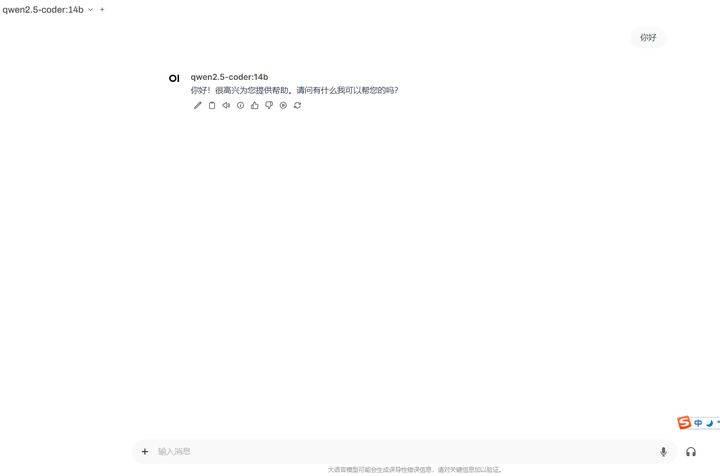

新建对话 使用一下

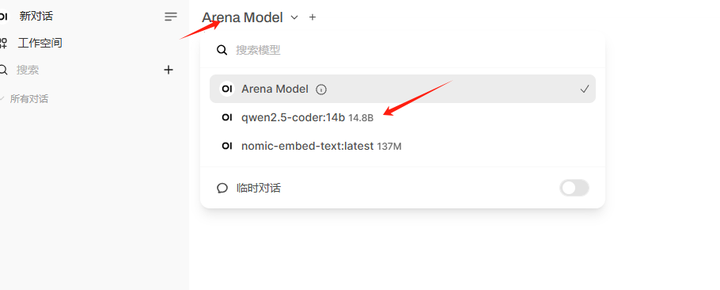

点击右上角新建对话-选择模型 -选择刚下好的模型qwen2.5-coder:14b

和其他ai界面雷同,使用方式也没什么不同